Si vous avez côtoyé les secteurs de l’Internet et de la technologie pendant un certain temps, vous pouvez avoir l’impression qu’il y a plus de bruit que de réalité dans un grand nombre de tendances et de prétendues innovations basées sur des mots à la mode. L’avènement du Web 2.0 au début des années quatre-vingt-dix a eu de la substance et a inauguré une nouvelle ère de sites web et d’applications plus collaboratifs et sociaux. Malgré tout ce qui a été écrit sur le Web 3.0, et malgré le désir sincère d’un autre changement de paradigme similaire dans l’interaction en ligne, il est difficile de voir un impact vraiment généralisé sur la façon dont les gens construisent et utilisent les technologies Web.

En ce qui concerne l’infrastructure Internet sous-jacente au web, il y a bien sûr eu des changements et des mises à niveau en cours de route (voir IPv6, TLS1.3, QUIC), mais aucun d’entre eux ne s’est traduit par des améliorations visibles pour l’utilisateur final qui ont créé un “facteur d’attraction” pour stimuler l’adoption. En effet, l’absence d’attraction du marché pour ces développements explique en grande partie pourquoi le déploiement reste souvent très disparate. Mais cela pourrait-il être sur le point de changer ?

L’Internet est lent

Si, comme moi, vous êtes en ligne depuis bien avant le début du millénaire, vous savez qu’attendre que les choses se passent faisait partie intégrante de l’utilisation de l’internet. Attendre que les modems commutés se connectent, attendre que les messages électroniques soient envoyés et livrés, attendre, parfois pendant des jours, que les téléchargements de toutes sortes se terminent. S’il est vrai qu’il y a une grande différence entre des réseaux toujours actifs qui prennent en charge le streaming vidéo et des réseaux connectés par intermittence qui prennent à peine en charge les interactions textuelles, bon nombre des frustrations de ces premiers jours sont toujours d’actualité. Malgré la généralisation des connexions Internet à large bande de plusieurs mégabits, voire de gigabits, les cris de “l’Internet est lent aujourd’hui” n’ont pas disparu de la liste des maux modernes qui peuvent nous frapper. Mais pourquoi ?

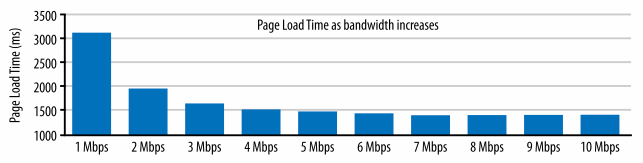

Alors que les fournisseurs d’accès à l’internet continuent de vanter la vitesse de leurs réseaux et proposent différents paliers de vitesse qui laissent entendre que plus la vitesse est élevée, meilleur est l’internet, on sait depuis longtemps qu’une bande passante supplémentaire offre des rendements décroissants en termes d’amélioration des performances. Le graphique ci-dessous, tiré d’une étude de Mike Belshe qui a finalement conduit au développement de QUIC, illustre clairement ce point. Alors que des gains importants peuvent être réalisés en termes de temps de chargement des pages web lorsque la bande passante augmente au-delà de 1 Mbps, ces gains sont marginaux lorsque la bande passante dépasse 3 Mbps. Ainsi, au-delà d’un certain point, l’augmentation de la bande passante ne contribuera pas à améliorer l’expérience de l’utilisateur en matière de performances Internet.

Le réseau est l’ordinateur

L’avènement de l’informatique en nuage et l’essor des applications web progressives signifient que le vieux slogan de Sun Microsystems, “le réseau est l’ordinateur”, est plus vrai que jamais. Mais comme le bon fonctionnement de nos applications (basées sur le web) dépend désormais d’interactions client-serveur constantes, le temps que prennent ces interactions (le retard du réseau, ou latence) est devenu le point de mire des chercheurs qui tentent de faire évoluer les performances de l’internet.

“Ma théorie ici est que lorsqu’une interface est plus rapide, vous vous sentez bien, et en fin de compte, ce qui revient à dire que vous vous sentez en contrôle. Le [application] ne me contrôle pas, c’est moi qui le contrôle. En fin de compte, ce sentiment de contrôle se traduit par le bonheur de chacun. Afin d’accroître le bonheur dans le monde, nous devons tous continuer à y travailler.”

Matt Mullenweg, WordPress

J’aime beaucoup cette citation de Matt Mullenweg, car elle explique pourquoi la mission consistant à minimiser la latence du réseau ne se limite pas à une amélioration progressive, mais peut en fait transformer l’expérience que les gens ont de l’internet et le type d’applications qui peuvent être largement prises en charge. Si l’augmentation de la bande passante n’est d’aucune utilité, que pouvons-nous faire pour réduire les délais du réseau à leur minimum théorique ?

Faible latence, faible perte, débit évolutif (L4S)

Lors d’une récente réunion de l’Internet Engineering Task Force (IETF), les participants au premier test d’interopérabilité d’une nouvelle technologie expérimentale appelée L4S ont présenté des résultats vraiment impressionnants. Pour tous les détails, voir la présentation de Greg White au groupe de travail sur les transports. En bref, ils ont montré que le système L4S permet d’obtenir une variation de retard inférieure à 10 millisecondes (ms) pour 99,9 % du trafic, contre une variation de retard de plus de 100 ms pour le trafic non traité. L’objectif de L4S est de réduire les retards dus aux files d’attente dans le réseau à“moins de 1 ms en moyenne et moins de 2 ms environ au 99e centile“. Les travaux réalisés lors du hackathon sur l’interopérabilité de l’IETF et les résultats présentés suggèrent que les chercheurs et les développeurs travaillant sur cette technologie sont très près d’atteindre ces objectifs.

Réduire de 90 ou 100 ms le délai d’attente des paquets (dans le pire des cas) peut sembler peu, jusqu’à ce que vous vous rappeliez le point précédent concernant la façon dont la plupart des sites Web et des applications Internet populaires ont tendance à fonctionner aujourd’hui. En raison des nombreux allers-retours entre le client et le serveur, la probabilité qu’un pic occasionnel dans le délai d’attente vienne gâcher votre expérience est assez élevée. Réduire la variation des délais pour l’ensemble du trafic à un niveau proche du minimum théorique constituerait une amélioration considérable des performances. Nous passerions d’une situation où tout le monde fait l’expérience frustrante d’un “Internet lent” (quelle que soit la “vitesse”) à une situation où cette expérience est rare, voire inexistante. Si on y arrive, je pense qu’on pourra vraiment commencer à parler d’Internet 2.0.

Y a-t-il un piège ? Il y a un piège.

Ça a l’air génial, non ? Bien sûr, il y a un piège. Il y a toujours un piège. Il y a généralement au moins trois participants à toute communication médiatisée par Internet : l’expéditeur, le destinataire et le réseau intermédiaire. L4S nécessite des changements dans ces trois domaines afin d’offrir tous ses avantages. Faire en sorte qu’un si grand nombre d’acteurs aux intérêts et aux motivations disparates prennent des mesures et, éventuellement, se coordonnent, est une tâche difficile. En fait, c’est exactement le type de problème d’incitation souvent cité pour expliquer pourquoi d’autres nouvelles technologies potentiellement bénéfiques n’ont pas été largement adoptées sur Internet.

Dans le cas de L4S, il y a une raison d’être optimiste, et cette raison est le “wow-factor” que j’ai mentionné précédemment. L’espoir des personnes qui travaillent au développement et à la démonstration de L4S est qu’il sera possible de développer et de démontrer des offres de produits convaincantes en fonction des niveaux de performance basés sur L4S, ce qui contribuera à leur adoption par l’industrie. L’éventail d’entreprises participant au hackathon sur l’interopérabilité à l’IETF suggère certainement que l’intérêt généralisé des fabricants de dispositifs, des opérateurs de réseaux et des fournisseurs de services d’application Internet pourrait déjà s’être concrétisé.

Nous pourrions être à l’aube d’un véritable changement d’étape dans la réactivité des applications Internet, vers un nouveau paradigme où un retard constamment faible pour tout le trafic donne aux utilisateurs finaux des niveaux de confiance et de satisfaction (le “bonheur” de Matt Mullenweg) sans précédent chaque fois qu’ils utilisent le réseau. Nous prévoyons de continuer à suivre et à rendre compte de l’évolution de L4S, alors suivez @isoc_pulse pour être sûr de suivre l’évolution de l’histoire sans délai.

Plus d’informations sur L4S

- Document sur l’architecture L4S (en cours)

- Présentation de l’IETF L4S Interop

- Conférence WWDC d’Apple :” Réduire les délais de mise en réseau pour une application plus réactive“.

- Ericsson et Deutsche Telekom font une démonstration de L4S dans la 5G

- NVIDIA explique l’impact potentiel sur les jeux sur Internet

Photo par Mathew Schwartz sur Unsplash